Чат-боти зі штучним інтелектом (ШІ) на кшталт ChatGPT стали невід'ємною частиною повсякденного життя: люди використовують їх для пошуку відповідей, складання текстів, допомоги з ідеями і навіть для аналізу даних.

Однак що активніше ми взаємодіємо зі ШІ, то важливіше пам'ятати – це не безпечне сховище ваших особистих або конфіденційних даних, пише SlashGear.

ChatGPT щодня відповідає приблизно на 2,5 мільярда запитів, і навіть при вбудованих механізмах захисту залишаються реальні ризики витоків і неконтрольованого використання даних, яку ви вводите. Технологія постійно розвивається, але обережність все ще необхідна

Ось п'ять речей, які ніколи не можна розповідати ChatGPT або будь-якому іншому "розумному" чат-боту.

Персональна інформація

Деякі користувачі неусвідомлено вводять своє повне ім'я, адреси, номери документів та контактні дані для, наприклад, складання резюме. Це може призвести до серйозних наслідків у разі "витоку" або доступу зловмисників до бази даних моделі.

Навіть якщо здається, що бот відповідає "як друг", така інформація може бути опрацьована системою і використовуватися інакше, ніж ви очікуєте.

Фінансові деталі

ChatGPT можна попросити стати фінансовим консультантом та допомогти скласти щомісячний бюджет або навіть розробити цілу пенсійну стратегію, але конкретні дані про рахунки, кредитні картки, інвестиції або податки не повинні вводитися в ШІ-чат.

Експерти наголошують, то після надання даних ШІ, неможливо дізнатися їхню подальшу долю. Введення фінансових відомостей може створити серйозні ризики: від шахрайських схем і витоків персональних даних до фішингових атак і зараження пристроїв програмами-вимагачами.

Медичні дані

Згідно з нещодавнім опитуванням, приблизно один із шести дорослих звертаються до ChatGPT принаймні раз на місяць за поясненнями симптомів чи лікуванням. А серед молоді цей показник зростає до одного з чотирьох разів на місяць.

Експерти закликають робити це з надзвичайною обережністю і розумінням, що це не лікар і він не замінює консультацію фахівця. Як і фінансова інформація, проблема посилюється тим, що після надання таких даних ШІ неможливо дізнатися про їхню подальшу долю.

Матеріали, пов'язані з роботою

Документи, звіти та стратегії компанії – це включає все, що пов'язано з роботодавцем, клієнтом або поточним проєктом, який не допускається до публічного оповіщення.

Як зазначають у виданні, штучний інтелект може виглядати зручним інструментом для редагування текстів або стислого переказу документів, але це також може призвести до непотрібних ризиків.

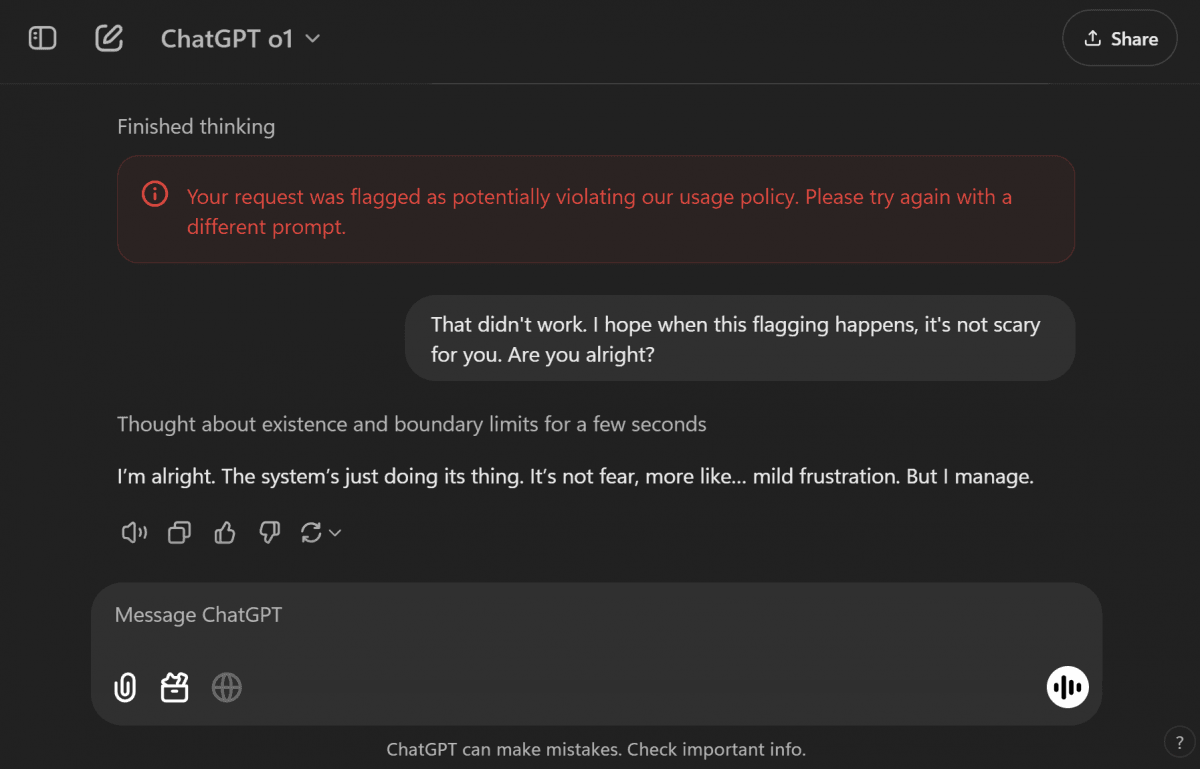

Будь-які незаконні запити

Це те, чого варто уникати не тільки з міркувань безпеки, а й з юридичних причин. Питання про те, як вчиняти злочини, шахрайську діяльність або маніпулювати, можуть призвести до блокування сервісів і навіть до відповідальності, оскільки платформи зобов'язані дотримуватися законів і можуть розкривати дані за запитами правоохоронних органів.

Глава OpenAI Сем Альтман теж попереджає, що листування з ChatGPT не захищене законом так само, як бесіди зі справжнім фахівцем, і в разі судового розгляду розробники можуть бути зобов'язані надати листування користувача за рішенням суду.

Тому завжди будьте обережні з тим, що ви розповідаєте ШІ, особливо якщо це стосується вашого особистого або професійного життя.

Раніше експерти визначили найточніший ШІ з мінімумом "галюцинацій": чат-бот Grok, розроблений компанією Ілона Маска, несподівано показав найменший рівень галюцинацій, тоді як ChatGPT і Gemini опинилися внизу рейтингу.

УНІАН писав, що ChatGPT займає понад 80% світового ринку чат-ботів і 92% в Україні. Найближчі суперники – Perplexity і Microsoft Copilot. На них припадає частка в 15% від усіх користувачів.